Адамның дауысын салып, интимді фото жасай алады: Алаяқтар жасанды интеллектті айласын іске асыру үшін қалай қолданып жүр?

Интернет алаяқтар күннен-күнге адамдарды алдаудың жаңа тәсілдерін ойлап табуды жалғастыруда. Айла-шарғысын жүзеге асыру үшін олар енді жасанды интеллектті қолдана бастаған. Жақында желіде экс-президент Нұрсұлтан Назарбаевтың ағылшын тілінде қазақстандықтарға жолдау жасаған, Тоқаевтың Илон Маск платформасына инвестиция салуға шақырған видеосы тарады. Кейін оның дипфейк (deepfake) екені анықталды. HeyGen нейрондық желісі бейнені сапалы өңдегені сонша, Назарбаев пен Тоқаевқа тән мимиканы әрі оның дауысын келтірген. Осы ретте бүгін жасанды интеллект арқылы таралып жүрген алаяқтық жүйелеріне тоқталамыз. Stan.kz тілшісі шолу жасады.

Дипфейк – жасанды интеллект арқылы өңделген фотосуреттер, бейнелер немесе аудиожазбалар. Термин "deepfake" – "терең" және "жалған" деген сөзден шыққан, яғни кеңінен алдау дегенді мағынаны білдіреді. Бұл технология адамдардың бейнелерін пайдаланып, оларды сөйлетіп, кез келген дауысты салады, сонымен қатар ешқашан айтпаған сөздерді айтқызуы мүмкін.

Дипфейктер 2016 жылы пайда болғанымен, қарапайым қолданушылар бұл бағдарламаларға қолжеткізе алмаған әрі дипфейк бағдарламалары өте қымбат болды. 2023 жылдан бастап ол барлық интернет қолданушыға қолжетімді, мұның салдары алаяқтықтың кеңінен тарауына әкелді.

Дауысты қолдану

Жасанды интеллектінің әсерінен кеңінен тараған алаяқтықтың бірі – өзгенің дауысын қолдану. Алаяқ жасанды интеллектіге айту керек сөздерді жазып береді де, бір адамның дауысы жазылған аудиофайлды жүктейді. Сол кезде ЖИ сол дауыспен жазылған мәтінді оқып береді. Осылайша кей адамдар арам пиғылмен жақынының дауысымен хабарласып, оны алдайды. Қазақстандық блогер Нейрогера дипфейктің көмегімен әжесінің дауысын салып, алаяқтың хабарласқанын айтты.

“Жақын арада атама әжем жылап хабарласып, қиын жағдайға тап болғанын және тез арада 50 мың теңге аударуды сұрады. Атам абдырап, ақша іздеп, не болды екен деп уайымдап қалды. Ол әжемнің басқа нөмірден хабарласқанына, дауысында өзгешеліктің барына назар аудармады. Өйткені қорқыныш адамның санасын улап тастайды”, – деді блогер.

Кейін олар оның басқа адам екенін біліп, желідегілерді сақ болуға шақырды.

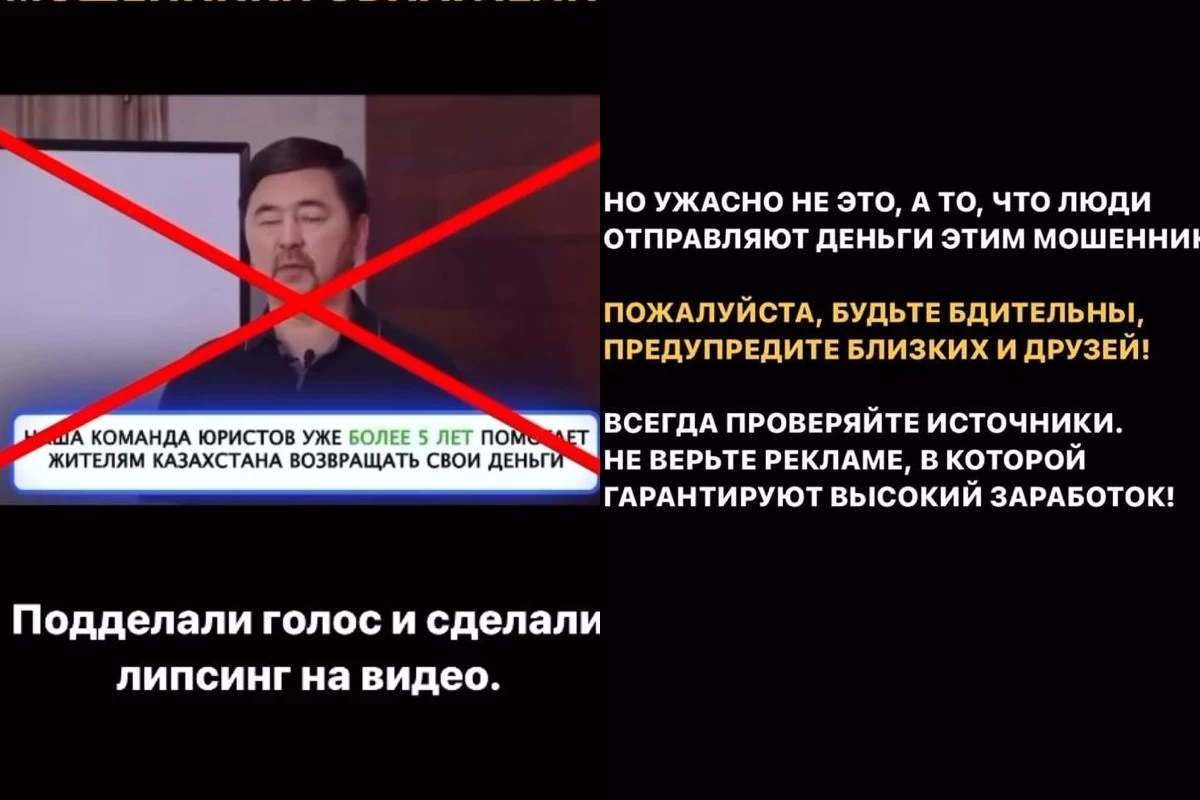

Танымал тұлғалардың видеосымен жарнама жасау

Жоғары технологиялардың көмегімен алаяқтар танымал тұлғалардың атынан сөйлеу қабілетіне де ие болды. Олар блогердің видеосын немесе суретін қолданып, оларға басқаша сөз айтқызады, жарнама жасатады. Дәл аудио-алаяқтық сынды қосымшаға адамның видеосын салып, оған қажетті мәтінді айтқызады.

Қазақстандық аралас жекпе-жек файтері Шавкат Рахмонов алаяқтар оның жеке басын адамдарды алдау үшін пайдаланып, жарнама жасағанын айтты.

Нейрожелі көмегімен жасалған спортшының бейнеролигінде ол "халал" әдіспен пайдаға кенеліп, Азамат есімді адам оған 500 мың теңге табуға көмектескенін айтады. Дипфейк басқа желі қолданушыларын да осылай ақша табуға шақырған.

Рахмонов өтірік жарнамаға алданбауға және жеңіл ақшаға қызықпауға шақырды.

Дәл осындай келеңсіз жағдайға қазақстандық инвестор, бизнесмен Марғұлан Сейсембай да тап болған. Оның видеосымен де жеңіл ақша табуға ынталандыратын жарнама тарады.

“Сорақысы – алаяқтардың әрекеті емес, адамдардың соған сеніп, ақша аударғаны. Өтініш, қырағы болыңыздар! Дереккөзді тексеріп жүріңіздер. Жеңіл әрі тез пайдаға кенелуге болады деп уәде беретін жарнамаларға сенбеңіздер!”, – деді бизнесмен.

Жасанды биометриялық деректер жасау

Digital Bridge форумының қатысушысы, IT-маман Ерлан Сарин жасанды интеллект адамдардың биометриялық деректері арқылы виртуалды нұсқасын, яғни көшірмесін жасап шығаруға қабілетті екенін айтты. Айтуынша, соны пайдаланып, алаяқтар адамның мобильді банк қосымшасына немесе биометрия арқылы кіретін басқа қосымшаларына кіріп кетуі мүмкін.

“Жасанды интеллекттің бір қауіпті тұсы – олар бара-бара биометриялық дерек, саусақ іздерін клондап, көшірмесін жасай алады. Мысалы, саусақ іздері немесе биометриялық деректің көмегімен сіздің жеке деректеріңізге қол сұғуы да мүмкін. Егер несие алу тәртібі қатаңдатылмаса, түріңізді ЖИ арқылы растап, атыңыздан несие ала алады”, – деді ол.

Интимді фото, видеомен бопсалау

Жасанды интеллектінің кесірінен кеңінен тараған тағы бір алаяқтық – интимді фото жасау. Қазіргі таңда адамның фотосындағы киімдерді алып тастап, жартылай немесе толық жалаңаш етіп шығаратын нейрожелілер пайда болған. Алаяқтар әлеуметтік желідегі жасөспірім қыздардың фотосын алып, олардан дипфейк арқылы интимді фото, видео жасап, сол арқылы қыздарды бопсалайды. Қажет соманы аудармаған жағдайда мұны желілерге таратып, ата-анасына, жақындарына жібереміз деп қорқытады.

Sensity ақпаратына сәйкес, 2019-2020 жылдар аралығында әлем бойынша 104 852 әйел дипфейктің кесірінен жалаңаштанып, қаскөйлердің құрығына түскен.

- Интимді фотомен бопсалаған кезде не істеу керек - Құқық қорғаушы жауап берді

Бұл кезде алаяқтың манипуляциясына ерік бермеу керек. Сізді бопсалаған барлық чаттың скриншотын жасап, полицияға жүгінген жөн. Мұндай әрекет “Бопсалау” бойынша тергеледі.

Дипфейкті түпнұсқадан қалай ажыратамыз?

Қазіргі таңда дипфейкті, дауыстың жасанды екенін анықтайтын арнайы құрылғылар шыққан жоқ. Сондықтан әр адамның сыни ойлап, оны өз бетінше тексере алуы маңызды. Сізге хабарласып тұрған адамның расымен жақыныңыз немесе нейрожелі екенін анықтау үшін жағдайды егжей-тегжей сұрау қажет.

- Қиын жағдайға түсіп қалдым деп айтса, қандай жағдай екенін, қашан болғанын және сол кезде жанында кім болғанын сұраңыз;

- Хабарласқан нөмірге өзіңіз қайта қоңырау шалыңыз. Кей жағдайда оларға қоңырау бармайды немесе олар дауысты қайта жасап үлгермей қалады;

- Егер сіз оның алаяқ екеніне сенімді болмасаңыз, жақыныңыздың өз нөміріне қайта қоңырау шалыңыз.

Қазақстандық блогер Нейрогера олармен ұрысып, жанжалдаспауға кеңес береді.

“Алаяқтардың көбі түрмеден хабарласады. Егер оларды ашуландырсаңыз, нөміріңізге жағымсыз хабарламаларды көптеп жіберуі мүмкін. Бір алаяқпен сөзге келіп қалғанымда, маған 5-7 минут ішінде әртүрлі нөмірден 200-ге жуық хабарлама мен қоңырау келді. Соның кесірінен телефоным қатып, жұмыс істей алмай қалды”, – деді қыз.

Ал бейнежазбада дипфейк технологиясының қолданылғанын анықтау үшін Массачусетс технологиялық институтының мамандары сегіз сұрақ қоюды ұсынды.

- Қозғалыс кезінде немесе сөйлеп жатқанда адамның беті өзгеріп, қозғала ма?

- Видеодағы адамның беті тым тегіс немесе қыртыс болып көрінбей ме? Терісі тегіс болса, көзінің айналасы, шашы қандай?

- Көзі мен қасына көлеңке түсе ме? Дипфейк табиғи жарықты толығымен жеткізе алмайды.

- Көзілдірікте қарама-қарсы беттегі нәрсе байқала ма? Адам қозғалған кезде ол өзгере ме?

- Бетіндегі меңдер шынайы көріне ме?

- Адам жыпылықтай ма? Қаншалықты жиі жыпылықтайды?

- Еріннің пішіні мен түсіне назар аударыңыз. Олар беттің қалған бөлігіне сәйкес келе ме?

"8 наурызды тойламаймын": Қазақстандық әйелдер атаулы мерекеден не үшін бас тартқандарын айтты